OpenWRT 공유기로 WiFi extender/Repeater/Bridge 만들기

이것은 OpenWRT 유무선 공유기를 가지고, 기존에 존재하는 무선네트워크를 확장해서 유선으로 연결 가능한 원격 네트워크를 만드는 방법이다.

https://openwrt.org/docs/guide-user/network/wifi/relay_configuration 의 번역판이라고 보면 된다.

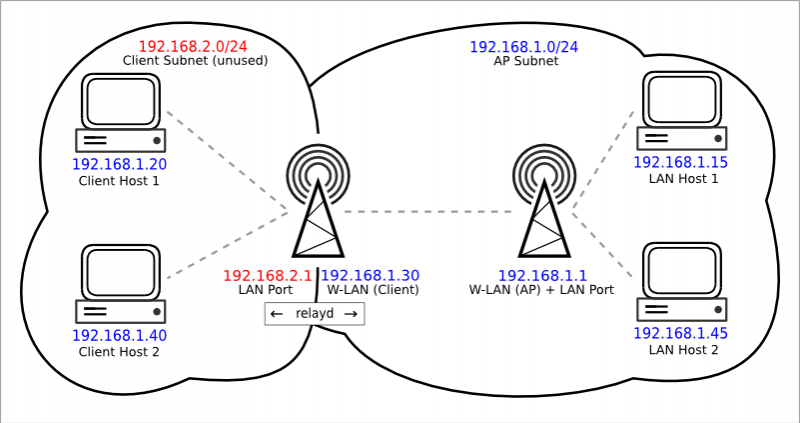

위 그림에서와 같이, 기존에 이미 192.168.1.1 이라는 유무선 공유기에 유무선 네트워크를 사용하고 있는 상황에서 유선 클라이언트들이 192.168.1.1 에 접근하기 너무 멀다면, 192.168.2.1/192.168.1.30 이라는 유무선공유기를 통해서, 기존 192.168.1.1 네트워크를 확장해서 사용하는 것이다.

0. openwrt 라우터 초기화

root@WClient2:~# firstboot && reboot now

This will erase all settings and remove any installed packages. Are you sure? [N/y]

y

/dev/mtdblock5 is mounted as /overlay, only erasing files

root@WClient2:~# Connection to 192.168.1.1 closed by remote host.

Connection to 192.168.1.1 closed.

1. relayd 설치

root@OpenWrt:~# opkg list |grep relayd

luci-proto-relay - git-19.307.61018-284918b - Support for relayd pseudo bridges

relayd - 2020-04-25-f4d759be-1 - Transparent routing / relay daemon

root@OpenWrt:~# opkg install relayd

Installing relayd (2020-04-25-f4d759be-1) to root...

Downloading https://downloads.openwrt.org/releases/21.02.1/packages/mips_24kc/base/relayd_2020-04-25-f4d759be-1_mips_24kc.ipk

Configuring relayd.

root@OpenWrt:~# opkg install luci-proto-relay

Installing luci-proto-relay (git-19.307.61018-284918b) to root...

Downloading https://downloads.openwrt.org/releases/21.02.1/packages/mips_24kc/luci/luci-proto-relay_git-19.307.61018-284918b_all.ipk

Configuring luci-proto-relay.

root@OpenWrt:~#

2. LAN 네트워크 IP 주소 변경 (반드시 ssh 콘솔로)

IP 주소만 수정. WClient 192.168.2.1

과 같이, 기존의 디폴트 192.168.1.1이 아닌 사설네트워크로 일종의 관리용 네트워크 대역을 설정하는 것이다.

root@OpenWrt:~# vi /etc/config/network

...

config interface 'lan'

option proto 'static'

option netmask '255.255.255.0'

option ip6assign '60'

option ipaddr '192.168.2.1'

option device 'br-lan'

...

...

ssh 로 로그인해서, /etc/config/network 파일 내용을 직접 수정하고 reboot.

2-1. LAN 네트워크의 DHCP 비활성화

웹 브라우저로 192.168.2.1로 로그인한 다음,

Network 페이지의 Interfaces 로 간 다음, LAN 항목의 EDIT로 들어가서,

DHCP Server 설정 탭에 가서, Ignore interface 네모에 체크하여, DHCP 비활성화 시킨다.

3. 무선랜 클라이언트 설정

wireless 페이지로 이동하여, 네트워크에서 Scan을 누르고, 원하는 무선 네트워크에 가입한다.

예제) SCAN 해서, KIM 네트워크를 찾아서, 클릭하고 들어간다. WPA 패스워드를 입력한다.

Name of the new network 는 wwan 이라고 그대로 둔다.

Assign firewall-zone 에서 lan을 지정한다.

3-1. 무선 디바이스 설정

wifi의 디바이스 설정으로 오면,

Operating frequency를 반드시 잘 설정해야만 한다. 우리가 가입하려고 하는 무선네트워크와 동일한 mode 여야 한다.

Channel은 다른 클라이언트들과 겹치지 않게 한다.

4. 리피터 repeater 인터페이스 생성

Interface 페이지로 이동하여, Add New Interface 를 클릭

Name에 repeater_bridge 를 입력 ※ 원하는 다른 이름을 넣어도 되는데, 직관적인 이름 사용

Protocol에 Relay bridge 를 선택

※ 만약 Relay bridge가 없다면, 앞 과정에서 relayd 설치하고 나서, reboot를 안했을 수도 있으므로,

relayd를 설치하고 장비 리부팅하고, 다시 들어오면 된다.

4-1. repeater_bridge 인터페이스 설정

Protocol은 Relay bridge로 그대로 두고, Relay between networks 에서 lan과 wwan을 선택

제일 중요한 것이 Local IPv4 address인데, 여기에는 실제 Relay 되는 네트워크 대역의 IP를 써야한다.

예제) 앞에서 관리용 목적으로 LAN 네트워크를 192.168.2.1를 선택했는데, 이것과 관련된 것을 쓰는 것이 아니고,

실제 무선네트워크에 Client로 연결해서 사용되는 네트워크 대역에서 이 장비에 할당할 IP를 써주는 것이다.

위 그림에서 보는 바와 같이, 기존 유무선공유기 네트워크가 192.168.1.1/24 대역이므로, 192.168.1.30을 써주면 된다.

4-2. repeater_bridge 파이어월 설정

repeater_bridge의 Firewall Settings 로 가서,

Assign firewall-zone에서 lan 을 선택한다.

5. 장비 재부팅 후, 확인사항

무선 네트워크에 잘 가입되어 있는지 확인!!

Firewall - Zone Settings에 가서, Zones 영역에 lan, repeater_bridge, wwan이 같이 묶여서, wan으로 모두 accept 되고 있는 지를 확인!!

장비에 유선으로 연결된 컴퓨터가 무선네트워크 IP를 dhcp로 잘 가져오는 것을 확인!!

이것으로 끝~!!